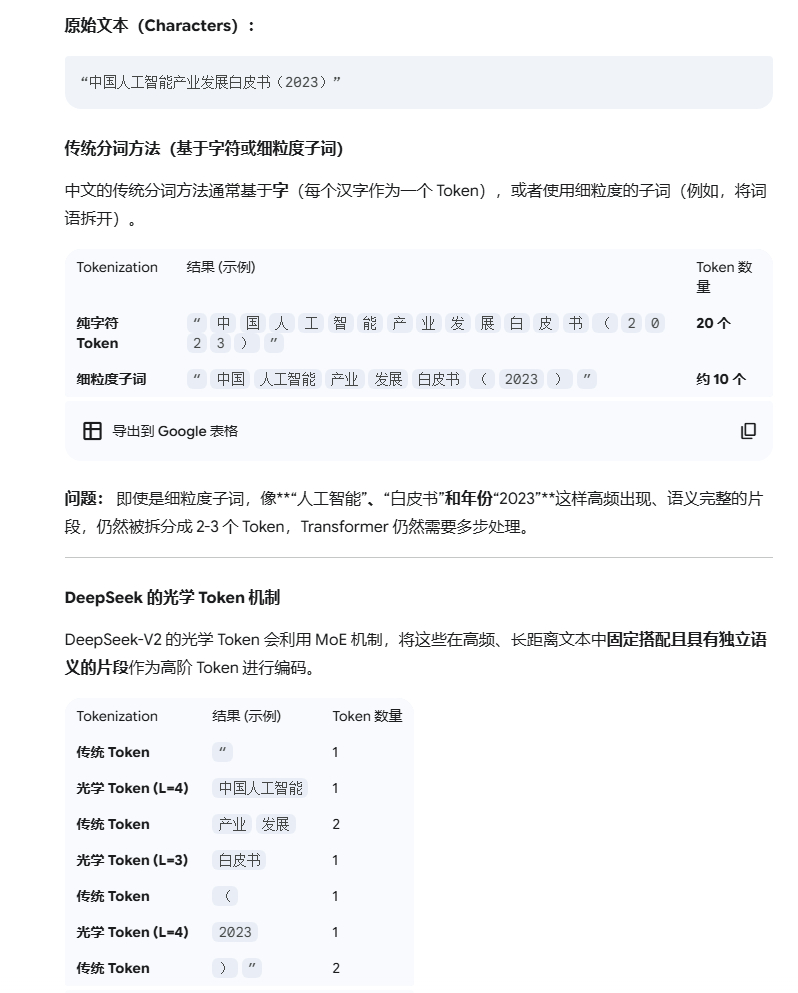

那个DeepSeek的什么光学分词,光学token,我看了,就是分词的时候,尽可能选择长词。。。老概念了。 动机也很简单,就是注意力机制需要全部token进行计算KQV,复杂度是token长度的平方复杂度,极其消耗,如果压缩token的数量,可以大大节约计算开销,然后就把分词从短词,延生到长词,就压缩了。。

不是网络上有人说的,一段话当初一个token,如果一段话当成一个光学token,那么这种token基本上接近随机出现,当信息是随机出现,就没有信息了。。

分词选择长词,一定是一个趋势,切词不要切太碎了,信息反而不聚焦,当然也不能太长,要实事求是,符合语义的自然切分。国内现在搞大模型,各种省显存,省算力,这方面创新投入是极大的,一旦我们解决了算力,喷涌而来的power是非常可怕的。