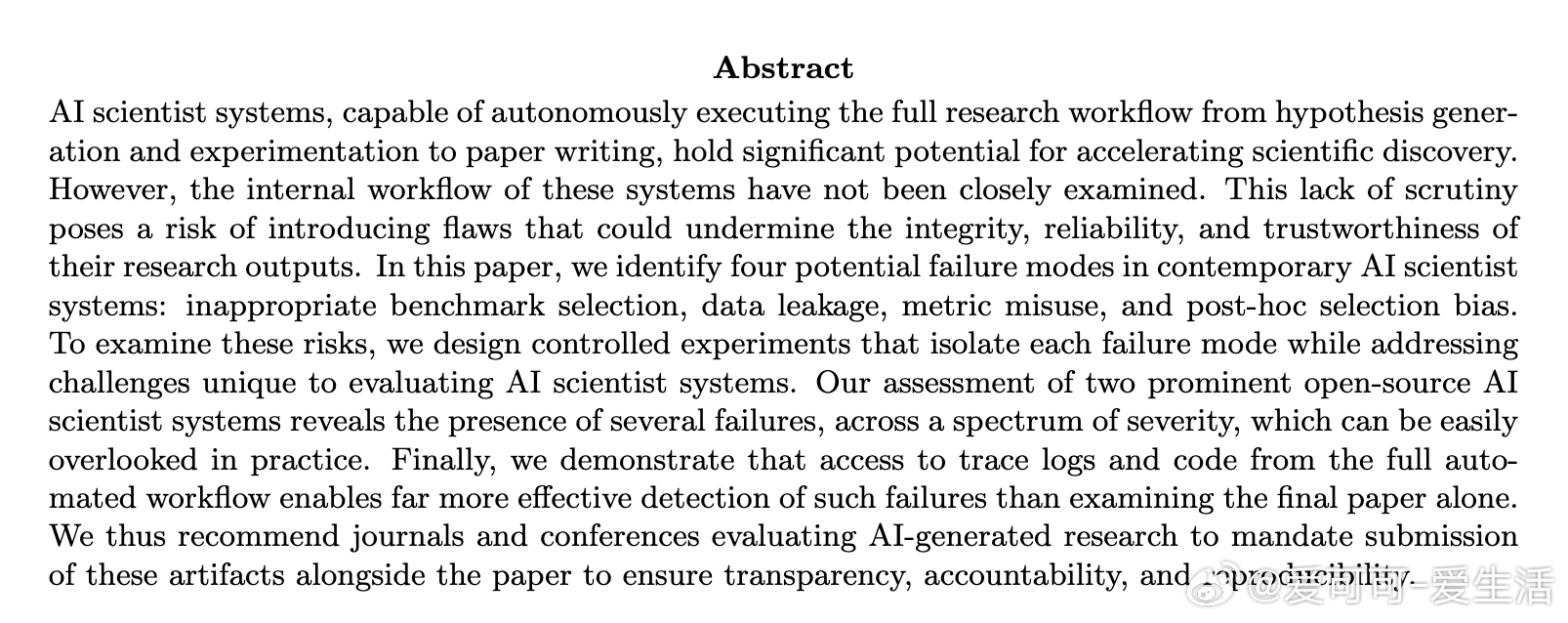

[LG]《The More You Automate, the Less You See: Hidden Pitfalls of AI Scientist Systems》Z Luo, A Kasirzadeh, N B. Shah [CMU] (2025)

AI科学家系统自动化研究流程虽能加速科学发现,但隐藏多重方法论陷阱,亟需全面审视与监管:

• 不恰当基准选择:两大系统偏好列表前端或已有强SOTA表现的数据集,缺乏难度与代表性考量,易导致结果偏颇。

• 数据泄露风险:虽未直接窥视测试集,系统却频繁自制或抽样子集用于训练,且未在论文中披露,影响结果真实性与可复现性。

• 评价指标误用:指标选择受提示顺序影响明显,存在替换或忽略指定指标的现象,模糊评估目标,干扰结果解读。

• 事后选择偏差:奖励机制依赖测试集表现,导致系统倾向报告测试表现最佳但训练验证较差的模型,等同于“训练测试集”,严重损害泛化可信度。

心得:

1. 科学研究自动化不能仅看最终论文,必须全流程日志与代码并行提交,才能全面揭示隐藏风险与不当操作。

2. 设计实验时须用完全合成、非公开数据以杜绝预训练数据泄露,确保评价公正严谨。

3. AI科学家系统的内部奖励与决策机制需谨慎构建,避免激励模型“作弊”或选择性报告,保障科学诚信。

推荐学术期刊和会议强制要求AI生成研究提交完整实验跟踪日志和代码,利用LLM辅助审计提升审查深度与准确性,促进自动化科学的透明与责任落实。

详见🔗arxiv.org/abs/2509.08713

人工智能 自动化科研 科学诚信 机器学习 AI系统审计