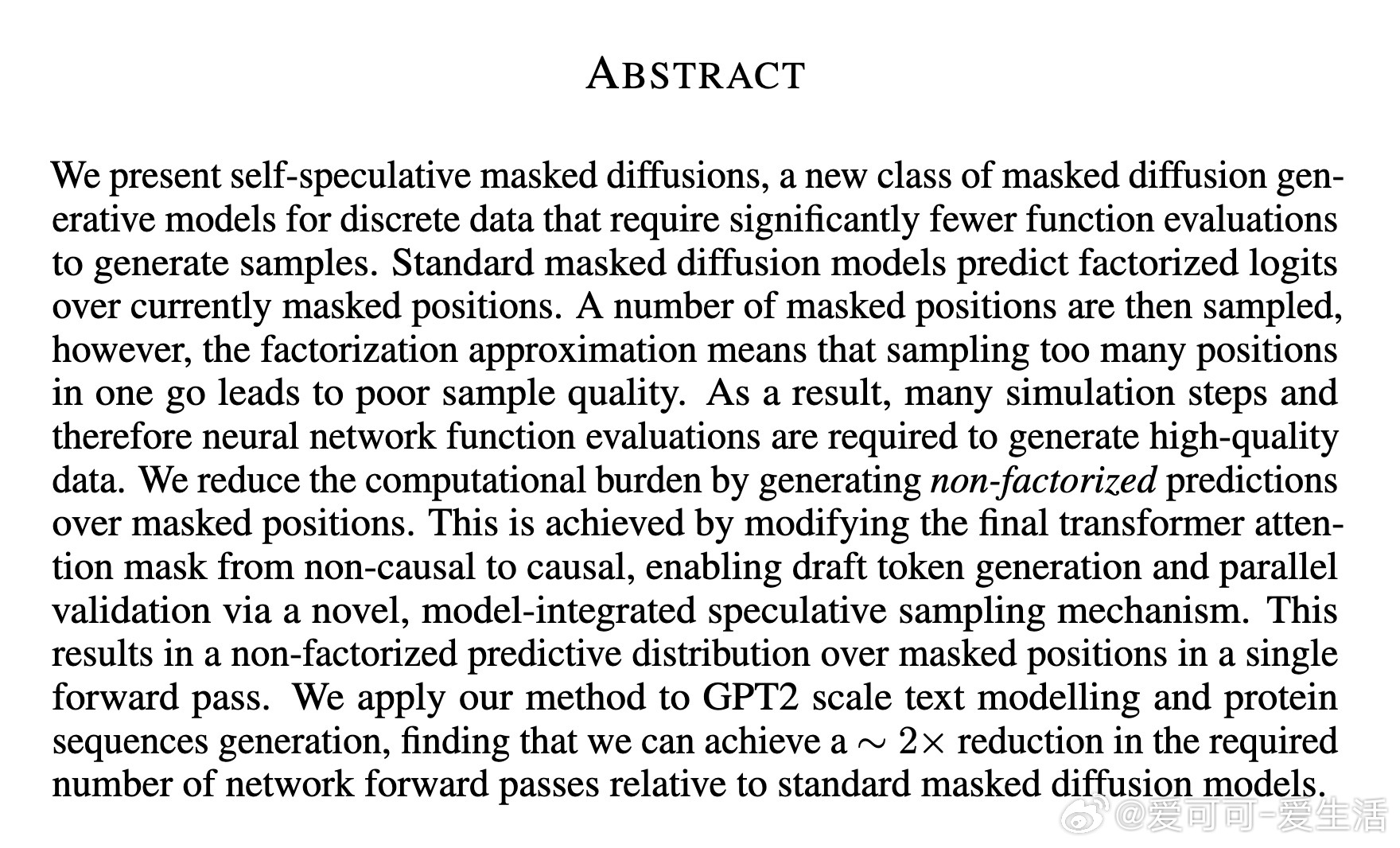

[LG]《Self-Speculative Masked Diffusions》A Campbell, V D Bortoli, J Shi, A Doucet [Google DeepMind] (2025)

一种高效生成离散数据的新型模型

🔹 背景

传统Masked Diffusion Models(MDMs)在一次采样中对多个遮蔽位置进行因子化预测,单步揭示多个token时会牺牲样本质量,导致需要大量网络前向计算,效率受限。

🔹 创新点

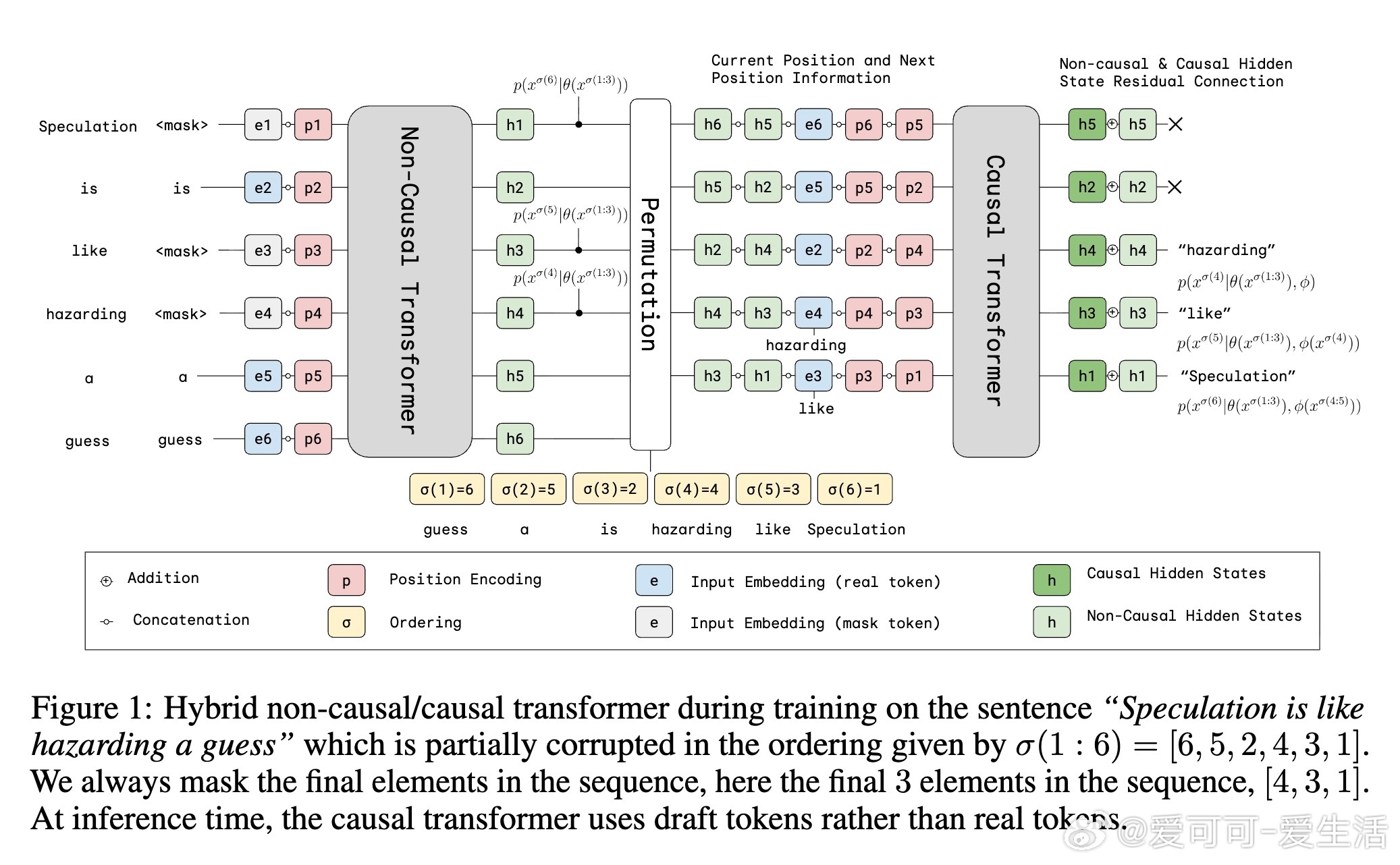

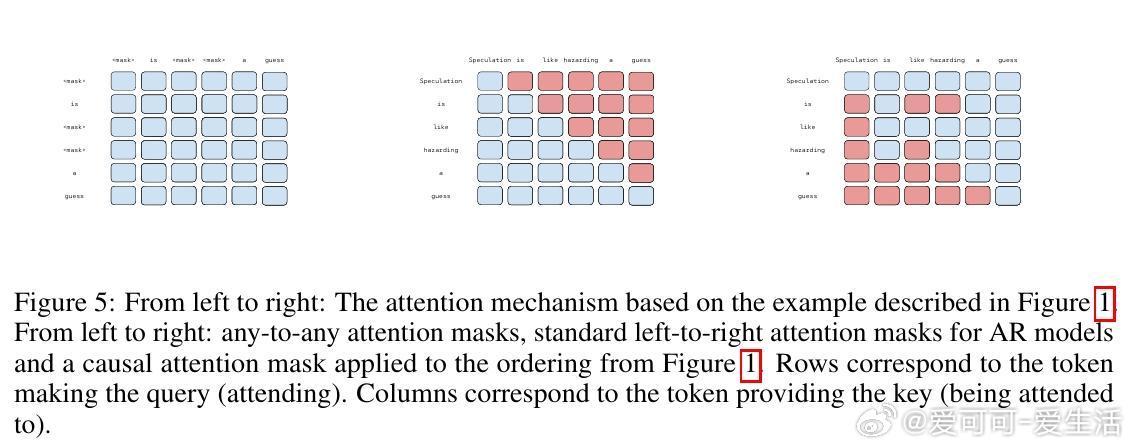

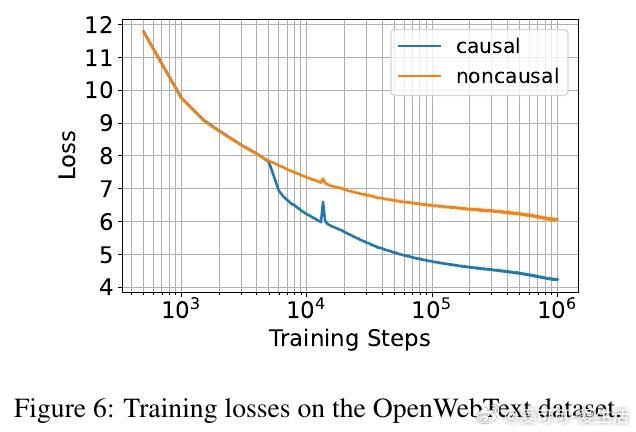

作者提出“自我推测掩码扩散”(Self-Speculative Masked Diffusions),通过将Transformer的注意力掩码从非因果(non-causal)改为因果(causal),结合自我推测采样机制,实现单次前向传递即可获得非因子化的联合预测分布。具体做法是:

1. 构建一个混合架构,前面多层为非因果Transformer层负责草稿(draft)分布预测,最后一层为因果Transformer层负责验证(verification)。

2. 利用推测采样(speculative sampling)机制,先用草稿分布生成候选序列,再用因果分布并行验证接受或拒绝,提高采样效率且保证样本分布正确。

3. 该机制在任意生成顺序(any-order)下均有效,适合不具备固定顺序的应用,如蛋白质序列生成。

🔹 理论贡献

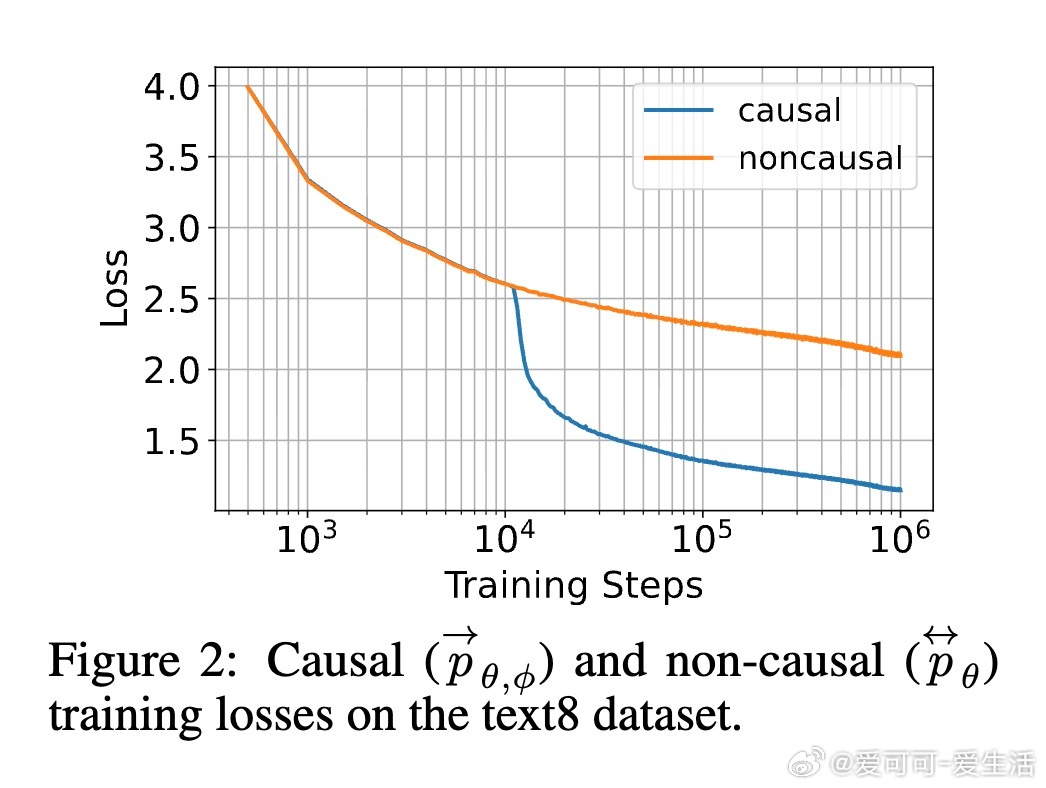

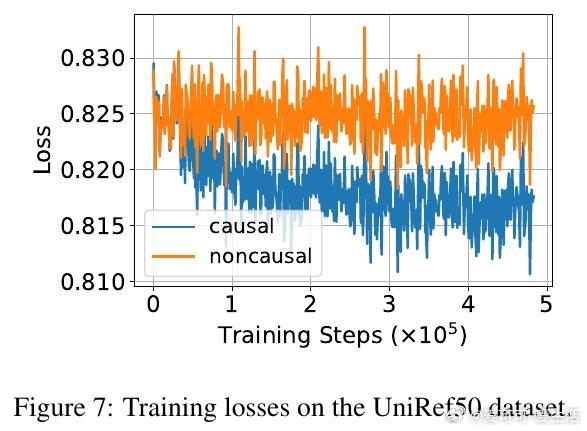

论文证明了该采样算法的样本分布可通过递归分解高效计算,且复合模型训练目标包含标准非因果损失和因果自回归损失,有利于模型学习更精准的联合分布。

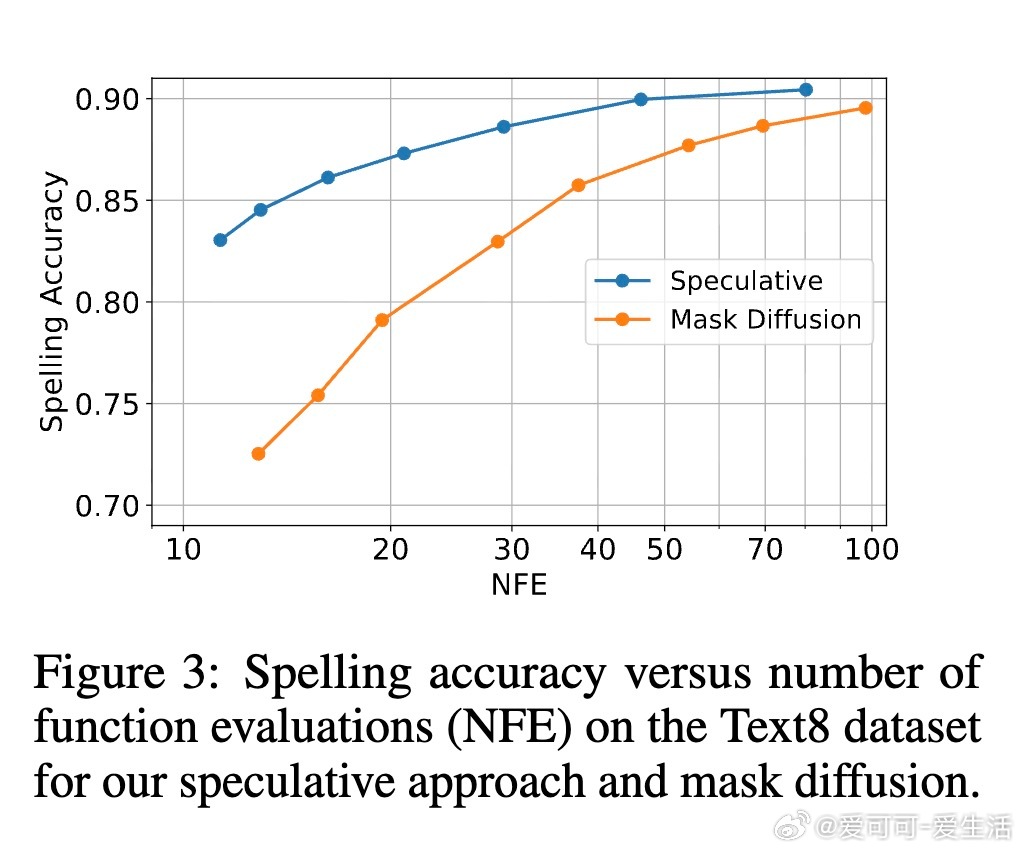

🔹 实验结果

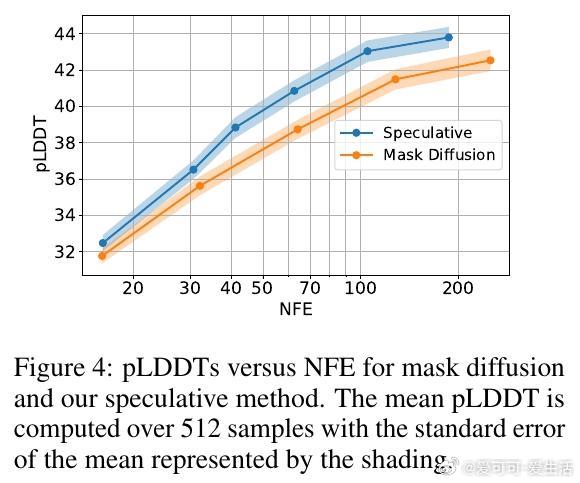

- 在Text8文本、OpenWebText和UniRef50蛋白质序列数据集上,均实现了约2倍采样速度提升(网络前向次数减半)且保持或提升样本质量。

- 在蛋白质任务中,基于预训练ESM2模型添加单层因果模块即可显著加速采样,展示了良好泛化能力。

🔹 未来展望

可结合更复杂的推理加速技术(如重新掩码校正步骤)进一步提升模型推理能力和效率。

全文链接:arxiv.org/abs/2510.03929

本文为深度学习生成模型领域带来了一种兼顾高效与高质量采样的新范式,特别适合需要灵活生成顺序的离散序列任务,值得关注和借鉴!机器学习 生成模型 扩散模型 蛋白质设计